Denne artikkelen er produsert og finansiert av Universitetet i Oslo - les mer.

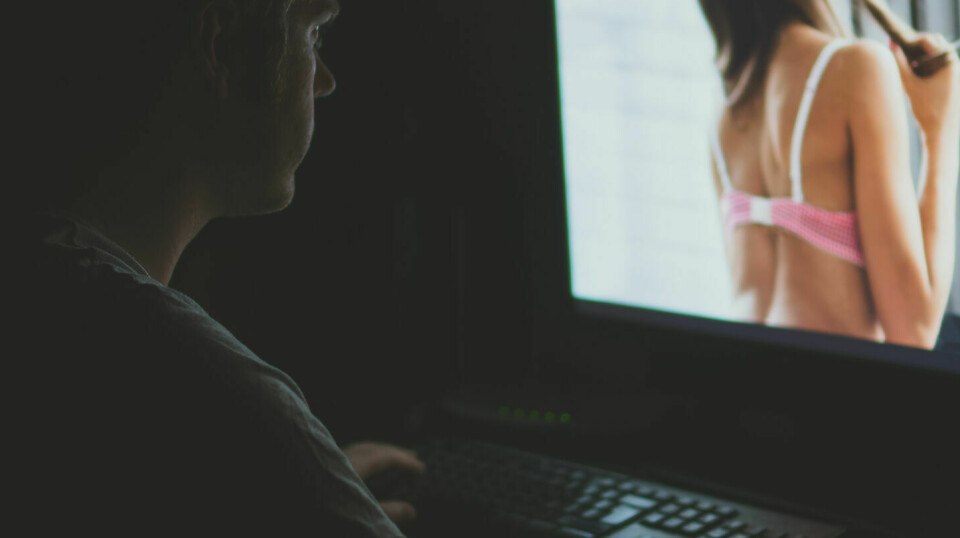

Da forskerne skulle finne data til språkmodellen, fant de mest porno

En språkmodell, slik som mye omtalte ChatGPT, kan ikke trenes på hva som helst. Modellen blir ikke bedre enn det den får inn.

Derfor bør den ikke mates med mye porno og fake news.

ChatGPT er det mest kjente eksempelet på en språkmodell, men språkmodeller brukes faktisk i en lang rekke ulike tjenester. Alt fra stavekontroll til søkemotorer eller tjenester for oversettelser bruker språkmodeller.

Forskere ved Universitetet i Oslo forklarer at dagens modeller, laget av store internasjonale selskaper, er i ferd med å bli et demokratisk problem.

– Vi bruker ordet demokratisering når vi snakker om forskningen vår, sier professor Stephan Oepen.

Jobber med 100 ulike europeiske språk

Sammen med sin kollega Andrey Kutuzov er han med på et stort europeisk språkteknologiprosjekt.

Målet er å lage språkmodeller for 100 ulike europeiske språk. Videre skal de gjøre tilgjengelig data og infrastruktur til offentlig og åpen forskning på språkmodeller.

– Dette er et teknologiområde vi ikke kan overlate til kommersielle markedsinteresser fordi det har en ekstrem påvirkningskraft, sier Oepen.

Ifølge ham og Kutuzov er det tre hovedproblemer med dagens utvikling av språkmodeller.

Det første er at det er private globale selskaper med tilgang til enorme datamengder og ressurser for beregning som er de fremste utviklerne av språkmodeller.

De har sine egne interesser og sin egen agenda med denne utviklingen. Det hele skjer bak lukkede dører og utfordrer åpen kunnskaps- og teknologiutvikling på et så sentralt område – og dermed demokratiet – på mange ulike måter.

Mangel på stavekontroll kan føre til språkdød

Det andre problemet handler om språket i seg selv.

Når store internasjonale selskaper utvikler språkmodeller, er det naturlig nok for å tjene deres egeninteresser. Det er mindre lukrativt å lage språkmodeller for små språk, slik som norsk eller islandsk.

Likevel er det viktig at språkmodeller finnes på disse språkene for alle som bruker dem i hverdagen.

– Det har vært kjent en stund at språk uten ordbøker har en tendens til å forsvinne. Det samme vil gjelde for maskinoversettelse av et språk, forklarer Kutuzov.

Han mener at dersom stave- og grammatikkkontrollen i tekstprogrammer som Word eller meldingstjenester på mobilen, søkemotorer på nett eller muligheten til å slå opp ord ikke fungerer bra nok, slutter folk å uttrykke seg på det språket.

– Norsk er ikke i umiddelbar fare, men den moderne digitale bruken vil kunne føre til det på sikt, sier Kutuzov.

Porno-problemet: Hvordan finne gode data?

Det siste problemet handler om data.

Selskaper som Google har en enorm tilgang til data. Dette gjør at de sitter på en gullgruve av informasjon som kan brukes til maskinlæring av språkmodeller.

Disse dataene er ikke åpne for andre enn selskapets egne forskere. Det er for eksempel ukjent hvor mye og hva slags data som ble brukt til å utvikle ChatGPT eller Googles Bard.

For at forskere skal kunne lage språkmodeller basert på maskinlæring, trenger de også store mengder data. Men hvor skal disse dataene komme fra?

Heldigvis var det krefter som på 1990-tallet forstod at internett er et kulturminne. Nettet er vår tids «runesteiner». Men for at det skal være mulig å forske på det, må noen ta vare på det.

Derfor ble organisasjonen Internet Archive stiftet. De har lagret internett siden 1996. Dette selskapet har High Performance Language Technologies-prosjektet (HPLT) ved Universitetet i Oslo nå inngått en samarbeidsavtale med.

Men en back up av internett kan ikke mates rett inn i en språkmodell.

Da forskerne begynte å undersøke vår tids kulturminne, fant de en hel del ukultur. Språkmodellen er bygget på maskinlæring, men den kan ikke bli bedre enn det den har fått å øve seg på. Derfor må forskerne finne en metode for å finne passende data.

– Porno var en enda større andel av internett enn vi var klar over, sier Oepen. Det er noen åpenbart uheldige trender som kan forsterkes hvis vi bruker data feil, slik som sexisme, rasisme, desinformasjon eller frekkhet.

– Det er et eget fagfelt å forske på hvordan man skal rense data slik at de kan brukes i språkmodeller, legger Kutuzov til.

Et av målene med prosjektet de to forskerne deltar i er å finne gode metoder for å hente ut data av god kvalitet i internett-arkivet.

– Det er en lang tradisjon for å tenke at mer data blir bedre, men vi ønsker mer kunnskap om hvordan data kan brukes effektivt og mer intelligent, sier Kutuzov.

Et demokratiseringsprosjekt

Det er flere mål med prosjektet. I hovedsak er det et forsøk på å svare på de tre nevnte problemene med dagens språkmodeller.

Der dagens modeller i hovedsak er trent på engelsk, vil HPLT legge mer vekt på andre språk og lage språkmodeller for 100 europeiske språk.

– Det er et demokratisk problem at disse modellene sjelden eller aldri trenes på små språk, mener Oepen og Kutuzov.

Prosjektet eies og drives av offentlige universiteter med støtte fra EU. Brorparten av dataene vil bli offentlig tilgjengelige. Disse dataene vil også kunne være et grunnlag for private bedrifter som kan bruke dem til å utvikle it-tjenester på små språk.

– Data fører til kunnskap, og det fører til makt. Derfor er dette demokratiseringsarbeid, mener de to forskerne.

– Google må ikke ha eksklusive tilgang til data og forskning. Det kan gi en bias til Googles egen-interesser, sier Oepen.

Et datasett på størrelse partikkelfysikk

Forskerne forteller at samarbeidet de har inngått, vil bidra til å gjøre data fra internett-arkivet åpent for forskere i Europa.

Det er snakk om enorme mengder informasjon. I størrelse er det snakk om omtrent syv petabyte med data. Det tilsvarer lagringskapasiteten til to millioner DVD-plater.

Størrelsen på internettarkivet er så stort at det i denne omgang er snakk om å bruke åtte prosent av den totale samlingen til Internet Archive. Det tilsvarer likevel drøyt 20 prosent av nasjonal kapasitet til forskningsdata i hele Norge, forklarer Oepen.

– Vanligvis er det forskere som jobber med klimadata, geovitenskap eller universet som har slike datasett, sier Oepen. Fra nå av vil også språkdata være i denne kategorien.

For å nyttiggjøre seg datamengden vil språkmodellene som skal utvikles, bli trent på en europeisk superdatamaskin i Finland.

Målet er likevel at modellene skal være enkle nok til å fungere på en vanlig datamaskin eller mobiltelefon etter at de er ferdig trent.

Å få ChatGPT til å fungere på en vanlig telefon vil være umulig, mener Oepen. Ifølge ham er dette en av fordelene med å lage språkmodellene mer spesialiserte og mindre.

– Jeg synes ChatGPT virker overvurdert. Det krever mye å bygge alt inn i én modell. Vårt argument er at en mindre spesialistmodell kan være bedre på ett språk. Databehandling og lagring krever energi, og kostnaden for ChatGPT er til å grine av. Vi har mindre og mer spesifikke modeller som trenes på supercomputere, men det at de er små, gjør at vi kan bruke de på enklere datamaskiner også.

Ifølge Oepen er det superdatamaskinen LUMI som er på 3. plass over verdens sterkeste supercomputere, og Europas raskeste, som skal brukes til å trene språkmodellene.

I tillegg leverer det norske nasjonale selskap Sigma2 storskala forskningsinfrastruktur for tungregning og lagring av data.

Egentlig et infrastrukturprosjekt

– Dette prosjektet krever tilgang til kostbar infrastruktur. Det er så stort at ett universitet alene ikke kan stå for det. Derfor er europeisk samarbeid essensielt, sier Oepen.

Han forklarer at tilgang til data, samt prislappen for å drive med tungregning er noe av årsaken til at det til nå har vært vanskelig for forskere utenfor Google og tilsvarende selskaper å utvikle egne språkmodeller med maskinlæring fra store datasett.

Derfor mener han at dette prosjektet på mange måter er et infrastrukturprosjekt.

– Forskere i de store teknologiselskapene får helt andre tilganger til data enn det vi har mulighet til. I tillegg har Google tilgang til enorme regneressurser, sier Oepen.

Når BERT, som er Googles opprinnelige språkmodell fra 2019, eller ChatGPT trenes på språk, forklarer Oepen at dette er en form for dyplæring hvor modellen får en setning der et ord er tatt bort.

Modellen skal lære å forstå hva som mangler. Slik kan den forstår hvilke ord som brukes i en gitt sammenheng.

– Dette er en form for statistikk i storskala. Med denne metoden ser det nesten ut som den lærer mer enn bare ordrekkefølge, slik som underliggende grammatikk. Det er det som styrer hvordan vi skriver. Grammatikk er spesifikt for hvert språk. Derfor har det mye å si hva slags data den er trent på, sier Oepen.

Han og Kutuzov håper at dette prosjektet vil bidra til å ta vare på europeiske språk, samt tilrettelegge for åpen og reproduserbar forskning på språkteknologi.

Les også disse sakene fra Universitetet i Oslo:

-

Kunstig intelligens gjør falske nyheter mer troverdige

-

– Presterollen må gjennomtenkes på ny

-

– KI-bilder er ikke falske fotografier

-

Forsker: Vær glad for livets overraskelser

-

Ny beregning: Hvert år dør 3.900 nordmenn for tidlig av usunn mat

-

Alkoholskader oppstår raskere enn tidligere antatt, men det nytter å snakke om det

forskning.no vil gjerne høre fra deg!

Har du en tilbakemelding, spørsmål, ros eller kritikk? TA KONTAKT HER